Поки ми звикли називати чат-ботів на кшталт Gemini чи ChatGPT “роботами”, справжні роботи — з моторчиками, камерами і холодними металевими кінцівками — стрімко наближаються до того, щоб не лише говорити, а й діяти самостійно. Google DeepMind оголосила про нову віху: запуск Gemini Robotics On-Device, моделі штучного інтелекту для роботів, яка працює без підключення до хмари.

Це означає, що роботи зможуть функціонувати повністю автономно, що критично для середовищ із нестабільним інтернетом або високими вимогами до приватності — наприклад, у лікарнях чи на виробництві.

🤖 Що таке Gemini Robotics On-Device?

Це локальна VLA-модель (Vision-Language-Action) — штучний інтелект, який розуміє, що бачить (камера), що ви йому говорите (мовна команда), і що з цим робити (виконати дію). І все це — на самому пристрої, без постійного звернення до хмари.

На відміну від попередньої гібридної системи, де велика модель обчислювалась на сервері, нова працює повністю на самому роботі. Це означає менші затримки, більше швидкості й менше залежності від інтернету.

🧠 “Генеративна” поведінка: як це працює?

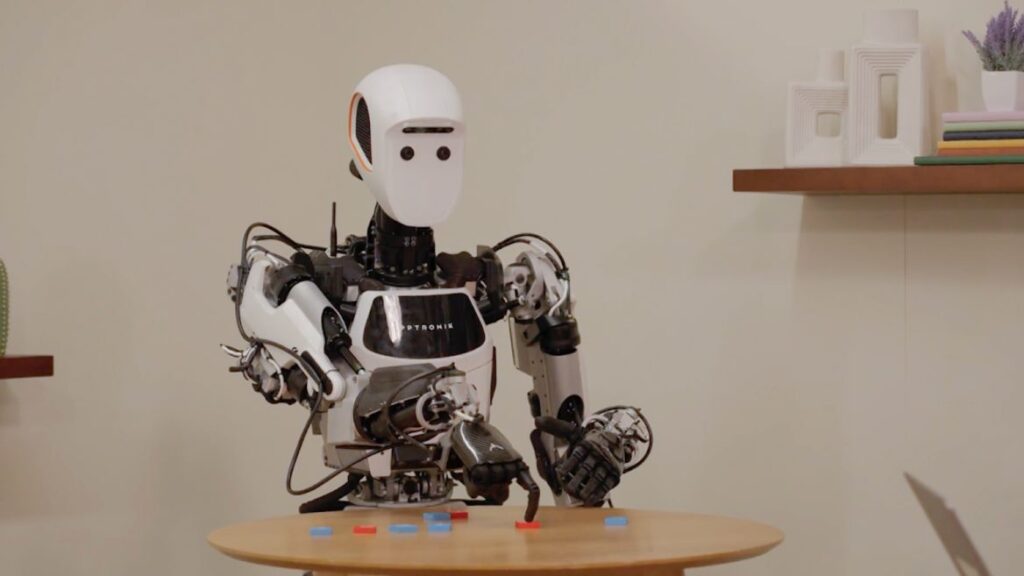

Carolina Parada, керівниця напряму робототехніки в Google DeepMind, пояснює: модель використовує мультимодальне розуміння світу, запозичене з Gemini. Це та сама технологія, яка дозволяє ШІ писати вірші, створювати картинки або генерувати код.

Зараз — вона ще й дозволяє зав’язувати шнурки.

І так, це не жарт. Один із прикладів — зав’язування взуття, що довгий час вважалося непідйомним завданням для роботів через складність дрібної моторики. Тепер Gemini справляється з цим без хмари.

🛠️ SDK і налаштування під конкретні завдання

Google також випустила SDK (набір інструментів для розробників), який дозволяє адаптувати модель до нових задач. І що цікаво — для навчання нової дії достатньо лише 50–100 демонстрацій.

Такі демонстрації — це керування роботом вручну (телеоперація), під час якої модель «дивиться», запам’ятовує й вчиться повторювати дію самостійно.

📉 А як щодо точності?

Хоч нова On-Device модель трохи поступається гібридній у точності, Parada зазначає, що більшість задач виконується “з коробки”. Роботи показують дивовижну здатність пристосовуватись до нових умов.

Проте для складних дій із багатьма кроками (наприклад, приготування бутерброда) все ще може знадобитися хмарна модель із потужнішим міркуванням.

🔐 Безпечні роботи — перш за все

Так, ми всі бачили фільми, де роботи виходять з-під контролю. Тож Google дуже серйозно ставиться до безпеки.

У повній версії Gemini Robotics діє багаторівнева система контролю:

- Модель «розмірковує», чи безпечно це робити взагалі.

- Потім VLA-рушій пропонує варіанти дій.

- І нарешті — низькорівневий контролер визначає, скільки сили можна застосовувати, як швидко рухатись тощо.

Але у випадку локальної моделі, відповідальність лягає на розробників. Google наполягає, щоб ті повторювали їхній підхід: додавали перевірки безпеки, інтегрували з API Gemini Live і створювали окремий безпечний контролер.

🚀 Де і як це тестувати?

Google відкрила Trusted Tester Program для розробників, які хочуть протестувати Gemini Robotics On-Device. Вони вважають, що саме ця модель — ідеальний кандидат для широкого поширення автономних роботів.

Цікаво, що ця версія базується ще на Gemini 2.0, а не на останній 2.5, яку вже хвалять за великі покращення в міркуванні та генерації. Це означає, що попереду — ще потужніші й розумніші роботи.

📌 Підсумок

Google знову ламає шаблони. Роботи вже не потребують постійного зв’язку з хмарою, можуть адаптуватися до нових ситуацій, і навіть зав’язувати шнурки. А головне — ця технологія вже доступна для тестування. Світ стоїть на порозі нової ери — еру самостійних, автономних і, сподіваємось, доброзичливих роботів.